Dynamic Passenger Route Guidance in the Multimodal Transit System With Graph Representation and Attention Based Deep Reinforcement Learning

基于图表示与深度强化学习的多模式公交线网动态乘客路径诱导策略研究

论文题目:Dynamic Passenger Route Guidance in the Multimodal Transit System With Graph Representation and Attention Based Deep Reinforcement Learning(基于图表示与深度强化学习的多模式公交线网动态乘客路径诱导策略研究)

论文作者:郝赫1,姚恩建1*,陈荣升1,潘龙1,王月1

论文期刊:IEEE Transactions On Intelligent Transportation Systems

论文网址:https://ieeexplore.ieee.org/abstract/document/10508234

摘要:近年来,有限的城市轨道交通运力逐渐无法满足日益增长的乘客出行需求,造成车站拥挤与无序、地铁网络过度饱和等危害城市轨道交通系统安全性的现象。考虑到当前大城市公共汽车运力闲置的现状,结合目前人工智能技术高速发展与海量出行需求数据的积累,面向地铁与公交组成的多模式公交线网的多样化运营场景以及实时动态路径诱导策略的现实需要,本文提出了一种强化学习(Reinforcement Learning,RL)算法生成多模式公交线网中的乘客路径诱导策略。提出的RL算法策略生成算法主要由图表示学习、卷积神经网络和自注意力机制组成,旨在缓解多模式公交线网的拥堵,同时改善乘客的出行体验并减少二氧化碳排放。基于北京多模式公交线网的示例验证表明,提出的RL算法能够很好地感知网络状态并生成自适应路径诱导策略,从而降低路段负载率,改善全网乘客的出行体验,并减少二氧化碳排放。对诱导接受度的分析表明,即使在乘客不完全遵守路径诱导的情况下,算法仍然有效。

关键词:深度强化学习;乘客路径诱导;图表示学习;多模式公交线网;自适应运行策略

1 引言

随着城市的扩张和出行者要求的提高,发展生态友好型的交通系统已成为全球各大城市之间的共识。城市轨道交通(Urban Rail Transit,URT)因其大运力、快速度和强准时性等特点,被广泛认为是一种高效的城市交通解决方案,其快速发展也吸引了越来越多的出行者。然而,日益增长的出行需求逐渐超过了URT的承载能力,导致全球大型地铁网络在高峰时段出现过度饱和,进而造成车站人满为患和站台无序拥堵等乱象,对乘客的出行体验和地铁系统的安全性产生负面影响。

为了缓解URT系统的运营压力,运营者和研究人员尝试开通新线或改用更高效的时刻表等策略来增加地铁网络的容量。然而,开通新线取决于当地土地使用情况和政策,同时也会带来更多的运营成本。此外,繁忙线路的发车频率也已增至极限。从需求侧角度来看,一些城市尝试制定需求管理策略来缓解高峰期运营压力,但客流控制手段降低了乘客进入URT系统的效率。

从另一个视角来看,在多模式公交系统中诱导乘客出行也是缓解拥堵和改善出行体验的另一种替代性选择。具体来说,公交系统为乘客提供出行服务,发展迅速。然而,随着大容量、高效率的URT系统以及需求响应型出行方式的发展,公交的市场占有率逐年下降,造成了公交运力资源的浪费。受此启发,在URT和公交系统集成的网络中引导乘客路径选择,有利于充分利用多模式公交能力,缓解URT系统中的拥堵,也有助于平衡不同交通方式之间的出行需求,最终实现更可持续和平衡的城市交通系统。

考虑到多模式公交网络的场景多样性以及实时生成路径诱导策略的需求,本文提出了一种新颖的强化学习(Reinforcement Learning,RL)算法,名为基于图表示和注意力机制的双延迟深度确定性策略梯度(Graph Representation and Attention Based TD3,GRA-TD3)算法,通过诱导乘客在多模式公交线网中的路径选择来缓解URT系统的过饱和状态。本研究的主要贡献如下:

将结构化深度网络嵌入算法集成到RL算法中,以捕获空间异构的出行需求,这有助于RL智能体在生成路径诱导策略时考虑后续全网络的出行需求;

结合卷积神经网络(CNN)和自注意力机制,设计了一种演员网络来处理状态表示和下一阶段的出行需求。其中CNN用于捕获网络的局部特征,自注意力机制用于动态分配对不同重要性路段的注意力;

综合考虑了网络负载、乘客效用、二氧化碳排放等优化目标,引入权重机制进行奖励函数设计,生成侧重点不同的策略。

2 问题提出

本研究旨在通过引导乘客在多模式公交网络中的路径选择来缓解URT系统的拥堵,同时考虑到乘客效用和CO2排放。

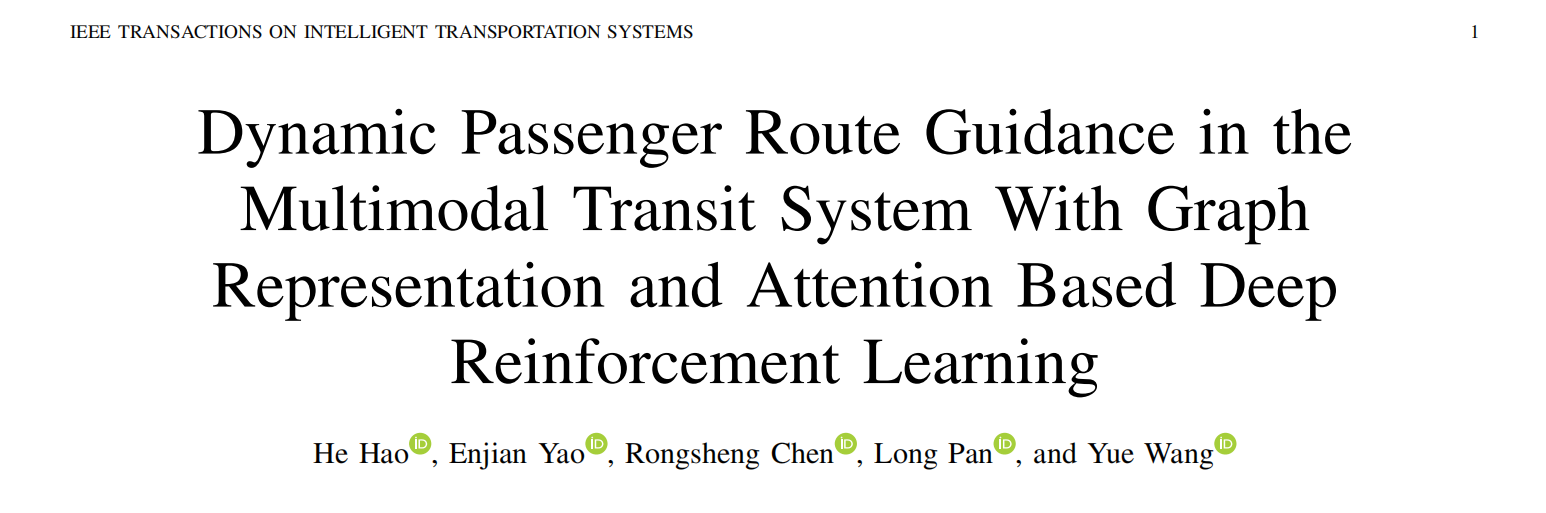

图1展示了乘客路径诱导策略的工作模式。在路径诱导下,地铁乘客由公交系统和地铁系统共同服务,在两个系统的换乘节点处进行换乘。对于运营商而言,公交系统得到了更好的利用,多模式公交网络的负荷得到了均衡,与此同时对于乘客而言,他们获得了更好的出行体验。

2.1 仿真环境

2.1.1 多模式公交线网构建

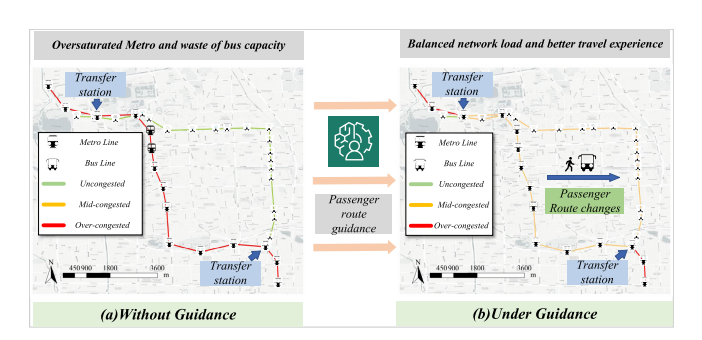

为方便起见,本研究重点关注采用乘客搭乘车辆的出行。图2显示了地铁和公交线网的集成耦合。如果公交站点与最近地铁站点的距离小于阈值,则将公交站点替换为地铁站点。地铁与公交线网的耦合规则使得多模式公交线网的规模小于或等于地铁与公交线网的总规模,从而加快了每一OD对之间的寻路速度。

2.1.2 车辆、乘客与RL智能体

车辆:车辆作为乘客的载体,直接与多模式公交网络交互并驱动仿真过程。本研究的车辆按照一定频率在多式联运网络上运行。

乘客:乘客的生命周期包括三个过程:创建、旅行和移除。考虑到本研究旨在缓解地铁系统的运营压力,只有地铁乘客才会收到引导信息。

RL智能体:RL智能体的作用是以一定的频率感知多模式公交系统的状态,生成能够最小化加权求和路段满载率,最大化乘客效用,并最小化二氧化碳排放的乘客路径诱导策略。

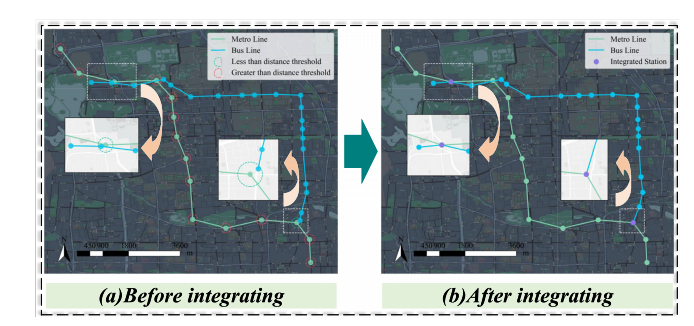

仿真系统的框架如图3所示:

2.2 状态、动作和奖励的定义

马尔可夫决策过程(Markov Decision Process,MDP)是强化学习算法的基础,由两个部分组成:RL智能体和环境,其中又包括状态、动作、策略和奖励。在仿真过程中,RL智能体不断更新策略以获得更大的奖励。状态、动作和奖励的设计如下:

状态

状态是从路段和节点两个方面提取出来的。路段满载率用于表征路段的状态。式(1)表示在时间t内截面s的路段满载率(0~1范围)。

![]()

式(2)表示在t时刻全网断面满载率的集合。

![]()

式(3) 为t时刻各车站候车的旅客人数,其中表示t时刻在n车站候车的乘客数量。

![]()

式(4)为时刻t的状态表示。所提出算法的演员网络会对这两种状态分别进行特征提取。

![]()

2. 动作空间

本文选取站点的被推荐程度构成动作集合A。是站点n在t时刻的动作,表示该站点在t时刻下的被推荐程度。时刻t下的动作集合如式(5)所示。

![]()

生成动作集合后,对于给定的O-D对,将推荐度(所有站点的推荐度之和)最高的作为诱导路径。

3. 奖励

奖励函数是强化学习的关键。为缓解多模式公交网络的拥堵,部分乘客可能被诱导选择低乘客出行体验、高二氧化碳排放的路径,这与公共交通系统设计时的考虑因素不符。因此,本文将环境和出行体验的效用纳入策略学习,表明奖励函数由三个部分组成。为了平衡这些奖励并且适应多样化运营场景,本文为这些组成部分分配了权重。

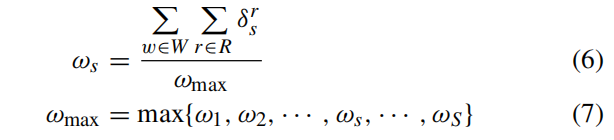

公交系统运营者主要关注多模式公交网络的运营效率,在本文中主要由路段满载率体现。在公交系统运营中,重要的路段应当被给予更高的关注。为此,本文选择边介数来表征路段的重要性。路段s的重要性可由式(6-7)计算。

采用最大-最小归一化将奖励值的取值范围规范到[0,1]。式(8-9)为奖励值。

乘客主要关注多模式公交网络提供的出行体验。结合随机效用理论,效用被选为乘客路径选择和评价出行体验的参考指标。如式(10)所示,本文整合出行时间、等待时间、出行成本和换乘次数来计算确定性效用。

![]()

式中为乘客选择路径k的效用,为路径k的出行时间(小时),为路径k所需的总等待时间(小时)。为路径k的换乘次数,为乘客选择路径k的出行费用,为对应变量的待估参数。

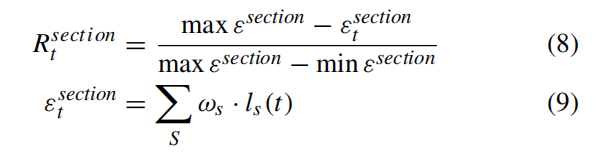

如式(11-12)所示,在乘客不受诱导的情况下,本文采用路径选择模型(Path-size Logit, PSL)模型计算乘客选择路径k的概率:

随机效用理论指出,乘客更倾向于选择效用最大的路径。因此,式(13-14)计算RL智能体提升乘客效用的奖励。

乘客效用奖励的引入可以缓解RL智能体在缓解网络拥堵的同时带来的乘客效用牺牲的程度。

政府可能关注乘客路径诱导对二氧化碳排放的影响,式(15)为乘客n选择路径k的碳排放。

![]()

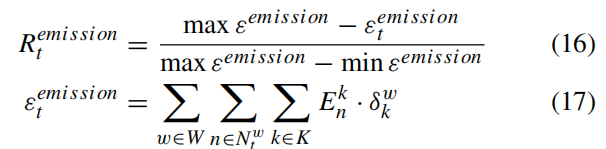

式中,为路径k对应交通方式的出行距离(km),为对应方式的排放因子。RL智能体降低碳排放的奖励计算如式(16-17)所示。

式中,为t时刻全网乘客路径选择的碳排放总量,和代表可能的最大与最小碳排放。

RL智能体在状态下采用动作获取的总奖励值如式(18)所示。

![]()

式中,为不同类型奖励值的对应权重,根据运营者的运营重点进行调整。

3基于图表示与注意力机制的双延迟深度确定性策略梯度算法

3.1 结构化深度网络嵌入

下一阶段旅客出行需求会显著影响交通分布。例如,假设下一阶段乘客的备选路径经过拥堵路段。在这种情况下,RL智能体可以决定是否诱导这些乘客选择包括这些路段的路径,同时考虑这些乘客的数量。在这一部分中,我们介绍了用于提取下一阶段乘客出行需求特征的模块。然而,OD矩阵的稀疏特性给特征提取带来挑战。

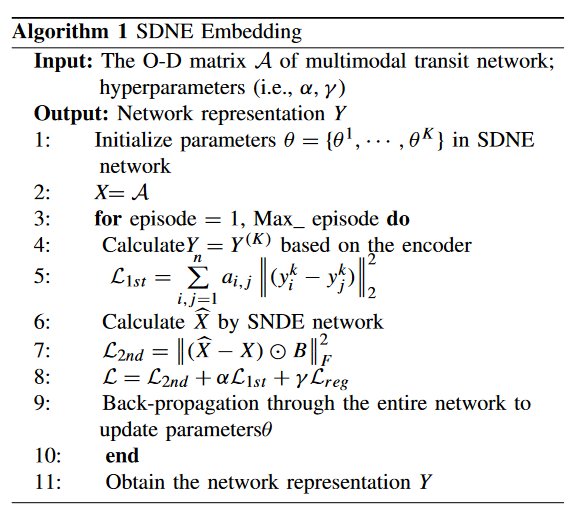

考虑到上述问题,本文应用结构化深度网络嵌入(Structural Deep Network Embedding, SDNE)生成稀疏O - D矩阵的嵌入表示。与图卷积网络相比,SDNE更加灵活,可以生成已知网络连通性的新节点的表示。SDNE的训练过程如下。

SDNE算法解决了OD矩阵的稀疏性问题,将相似节点表示为近似嵌入向量。这有助于RL智能体捕获多式联运网络中下一阶段的乘客出行需求。

3.2 GRA-TD3算法架构

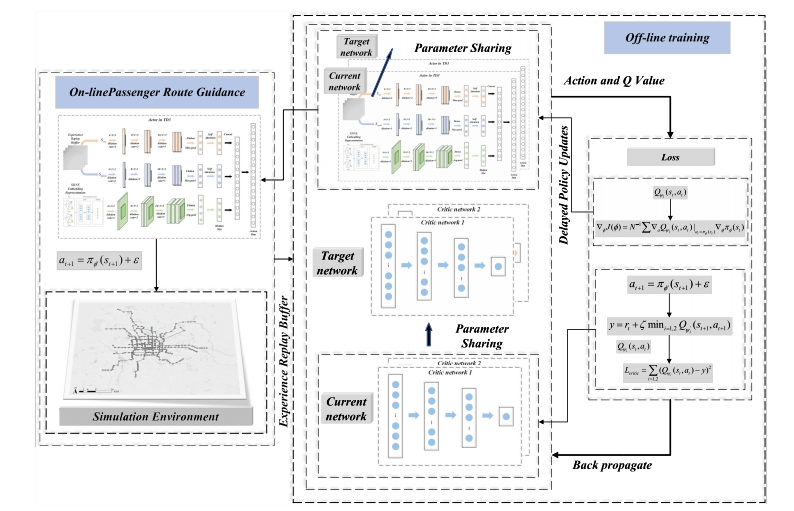

3.2.1 TD3

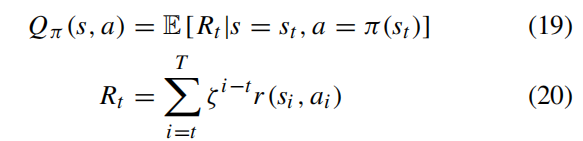

在介绍TD3算法之前,需要知道Q函数。

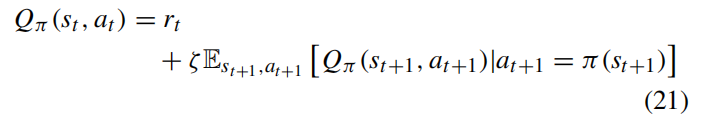

Qπ ( s , a)是在状态s中采取行动a并跟随π所获得的累积奖励的期望。一个状态-动作对的Q值与后续状态-动作对的Q值之间的关系如下:

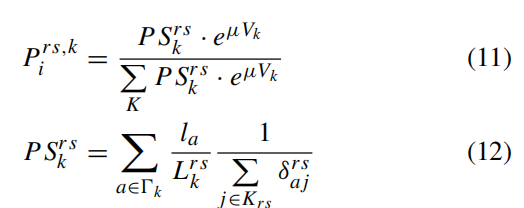

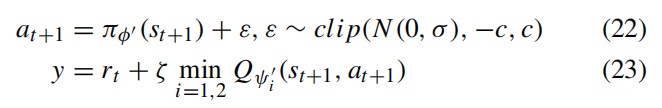

评论家的任务是准确的估计,以便评估状态s下采用动作a的表现。TD3算法中包含具有相同网络结构的两个当前评论家网络和两个目标评论家网络,分别用来估计和。目标评论家网络的输出如式(22-23):

式(24)为当前评论家网络的损失函数。

![]()

演员网络旨在通过在状态下采用动作来获取更大的Q值,其参数由确定性策略梯度算法更新,如式(25)所示。TD3算法流程如下。

![]()

3.2.2 GRA-TD3

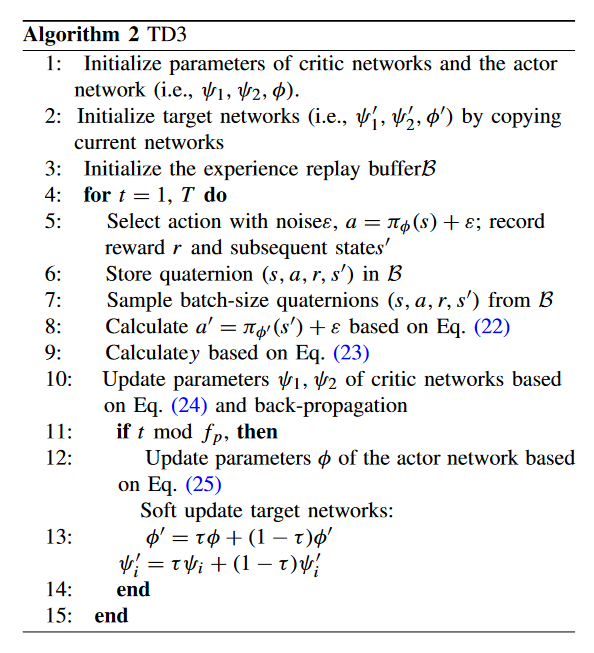

为了获得性能良好的路径诱导策略,本文设计了包括CNN和自注意力层的GRA模块作为TD3的演员网络,用于从多模式公交线网特征和SDNE计算得到的出行需求嵌入表示中提取特征并输出策略。本文提出的演员网络的框架如图 4所示,主要分为三个部分:特征提取、特征提取和乘客需求嵌入表示(Passenger Demand Embedding Representation, PDER)的特征提取。

由于处理和的网络类似,这里以处理的网络为例进行介绍。

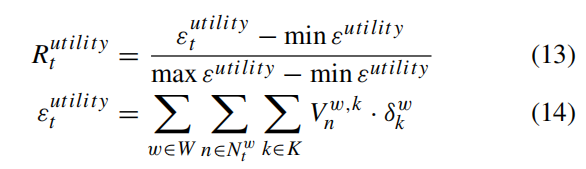

值得注意的是,考虑到多模式公交线网的规模较大,本文引入空洞卷积技巧扩张卷积核的感受野,并在不增加参数的基础上进行快速的特征提取[32]。另外,为了避免由连续的空洞卷积带来的网格效应,本文进一步引入混合空洞卷积技巧,即将卷积率设置为(1, 2, 5)。针对卷积后的特征向量,本文采用最大池化识别拥堵路段。随后采用压平以及自注意力层,用于为关键路段分配更高的关注度,如式(26)所示。

![]()

另外,SDNE计算得到的嵌入表示用于提取后续的乘客需求分布特征并辅助生成路径诱导策略。与上述状态的处理过程类似,本文采用三层空洞卷积,结合HDC原理对PDER进行处理,捕捉乘客出行需求的空间相关性。然后,利用平均池化来感知乘客出行需求量。最后,PDER被压平后通过全连接层(FC)重塑为隐空间大小。

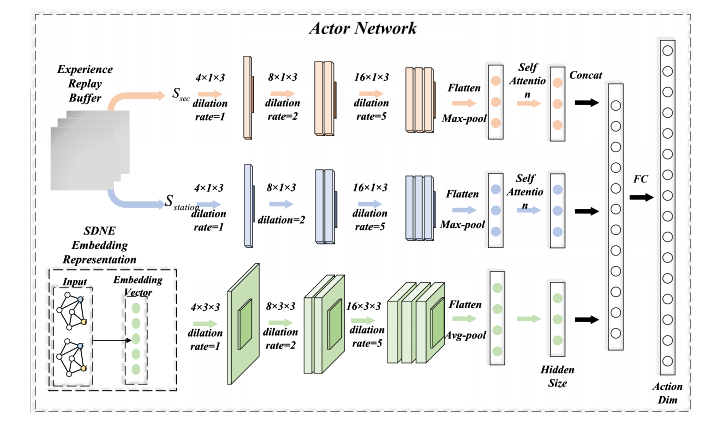

最终处理后的状态s和PDER被集成到隐空间,动作a采用FC输出。在本文中,采用三层FC构建评论家网络,以评估在状态s下采用动作a的Q值。最终得到的GRA-TD3算法包含6个网络:演员网络、目标演员网络、2个评论家网络、2个目标评论家网络,算法框架如图 5所示。

在训练过程中,GRA - TD3以一定的频率更新其演员和评论家网络。此外,在每个时刻t,执行器网络在当前状态生成动作,并记录奖励和后续奖励,为经验回放缓冲区提供新的数据。

4 仿真实验

4.1 环境搭建

本文基于北京市的多模式公共交通网络进行仿真环境搭建,包括379条线路(18条地铁线路和361条公交线路),包含断面11486个和站点3889个。所有的相关信息,包括站点位置、车辆发车时刻表、车辆速度、车辆定员等信息通过高德API获取。所有网络相关的数据均来自2022年。本研究结合刷卡数据和运营记录对网络结构进行了调整。在地铁网络中,我们主要使用IC卡数据删除新的线路,而在公交网络中,主要根据运营记录进行调整。仿真选取2016年5月11日具有典型出行模式的IC数据来模拟乘客出行需求。乘客路径诱导策略在早高峰时段7:00 ~ 10:00进行,频率为5 min。

随机用户均衡(Stochastic User Equilibrium, SUE)被用来仿真现实情况,并使用连续加权平均算法求解。为保证仿真的真实性,在进行早高峰乘客路径诱导工作前,本文首先模拟5:30-7:00的多模式公交网络的运营情况。

O - D对之间的路径集合是使用K短路算法生成的。以下假设针对接收诱导信息并选择其推荐路径的乘客提出。

乘客通过手机APP预定出行和接收诱导信息。

为了评估乘客路径诱导策略的表现,本文假设乘客在接受诱导信息之后会选择推荐路径。

考虑到第一条假设,随着出行即服务(Mobility as a Service,MaaS)理念的发展,北京已经进行了预约出行和多模式出行的试验。因此,本文假设O-D矩阵是可用的,乘客可以通过手机APP接收诱导信息。第二个假设是评估乘客路径诱导策略的性能。用于训练RL智能体的超参数如下表所示。

4.2 奖励

4.2.1 基准

为评估提出算法的效果,本文选取TD3,DDPG和Soft Actor Critic (SAC)三种RL算法框架,并向其分别添加GRA模块。另外,SUE作为一种有效的交通流分配方法,用于和RL算法进行比较。关于RL算法网络设置,TD3,DDPG和SAC算法的演员和评论家网络均采取3层FC。GRA-DDPG和GRA-SAC算法的演员网络和GRA-TD3的结构一致。GRA-TD3的演员网络可分为提取状态表示的模块1(Module 1)和用于提取下一阶段出行需求特征的模块2(Module 2)。为了验证这两个模块的有效性,本文将去掉Module 2的GRA-TD3算法和其他算法进行对比。

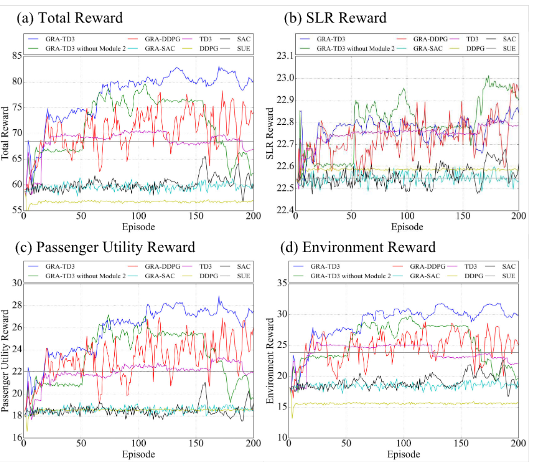

每次训练的总奖励值和不同类别的奖励值如图 6所示。对于给定的200次迭代,GRA-TD3 在大约100次迭代后收敛。图6证明GRA-TD3表现优于其他算法。此外,SUE 的总奖励为 68.46,优于DDPG 和SAC两种框架,劣于TD3框架,证明 TD3 在乘客路径诱导问题的适用性。集成GRA模块后,GRA-TD3和GRA-DDPG表现相较初始框架有所提升,表明了GRA模块对于诱导乘客路径选择的积极作用。加入Module 2后,GRA-TD3 表现出更高的稳定性并获得更大的总奖励,其原因可能是Module 2可以提取乘客出行需求特征,有助于建立动作和奖励之间的映射。

就子奖励值而言,三种子奖励值数值差异不大,表明权重机制发挥了作用,使得RL智能体对这三种奖励分配了近似的注意力。

在路段满载率奖励方面,与DDPG、SAC、GRA - SAC和SUE相比,其他RL算法在缓解拥堵方面能够获得更大的奖励。

乘客效用和碳排放奖励的变化趋势与总奖励的变化趋势相似。SUE在乘客效用和碳排放奖励方面比DDPG、SAC 和 GRA-SAC算法获得的奖励更大,也证明了合适的 RL 框架和提出的GRA模块的必要性。

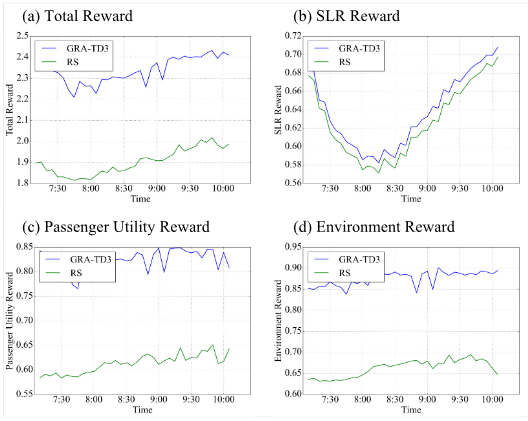

GRA-TD3和RS在不同奖励下的表现如图 7所示。可见,GRA-TD3 在各种奖励上都优于 RS,意味着GRA-TD3可以准确地识别多模式公交网络中每个O-D对的优势路径,从网络层面缓解网络拥堵,同时提高乘客效用并减少二氧化碳排放。

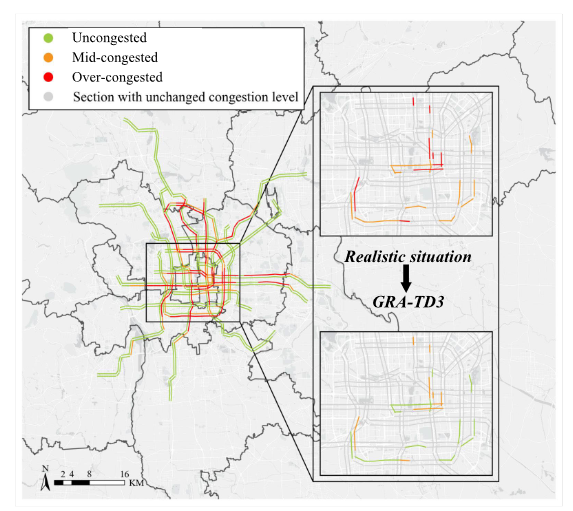

4.3 路段满载率

本节分析GRA-TD3对网络拥堵情况的缓解。首先,根据仿真时间内的平均路段满载率,将路段分为通畅(路段满载率≤0.6)、中度拥挤(0.6<路段满载率≤0.8)和重度拥挤(路段满载率>0.8)三种。使用GRA-TD3的地铁网络平均路段满载率如图 8所示。

注:灰色部分代表这两种方法得到的路段满载率分级相同

由图 8可见,GRA-TD3显着缓解了中心城市地铁网络的拥堵。此外,部分中度拥挤、重度拥挤路段得到缓解,改善了乘客出行体验,也提高了运营安全程度。总体而言,GRA-TD3可有效缓解多模式公交网络的拥堵。

4.4 诱导影响与乘客效用

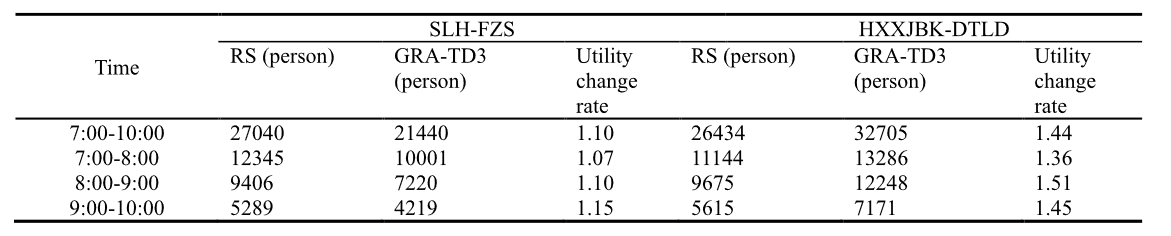

本节选取十里河—分钟寺(SLH-FZS)和惠新西街北口—大屯路东(HXXJBK-DTLD)两个路段,记录途经这两个路段的乘客数量以及乘客效用的变化。

SLH-FZS和HXXJBK-DTLD的途径乘客数量变化和效用变化率如表 1所示。对SLH-FZS来说,其早高峰期间通过的乘客数量从27040人减少到21440人(下降20.71%)。7:00-8:00、8:00-9:00和9:00-10:00三个时段分别下降了18.99%、23.24%和20.23%。原因可能是这两个站点的平均推荐度为-1,RL智能体不推荐包含该路段的路径。另外,经过SLH-FZS的乘客的出行体验略有下降。相反,经过HXXJBK-DTLD的乘客数量增加(两端车站推荐程度均为1),但与SLH-FZS类似,乘客经过HXXJBK-DTLD的平均效用变化率大于1,表明乘客的出行体验下降。两路段的效用变化比例均说明,诱导乘客选取不符合随机用户均衡的路径可能会导致其出行体验下降。

表 1 SLH-FZS和BJXZ-LLQD途径乘客的数量和效用变化。

注:本文计算得到的效用均为负值,效用变化比例大于1说明乘客出行体验下降。

4.5 碳排放变化

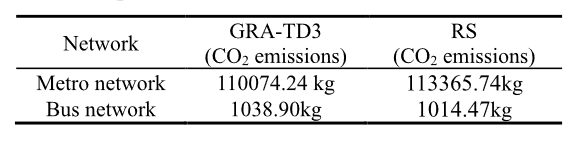

表 2显示了GRA-TD3 和RS 在公交和地铁系统中的二氧化碳排放量。在GRA-TD3的路径诱导下,公交系统的二氧化碳排放量增加了24.43kg,证明公交系统分担了一部分地铁客流。此外,地铁系统的二氧化碳排放量减少了3291.5kg,表明GRA-TD3减少了大量的多模式公共交通网络二氧化碳排放。

4.6 诱导难度和敏感性分析

虽然GRA-TD3的训练时间较长(经过约15小时的100轮训练后逐渐收敛),但训练后的模型能够快速生成动态实时的路径诱导策略,给出动作大约需要0.08秒,最终生成诱导路径集合大约需要0.13秒。

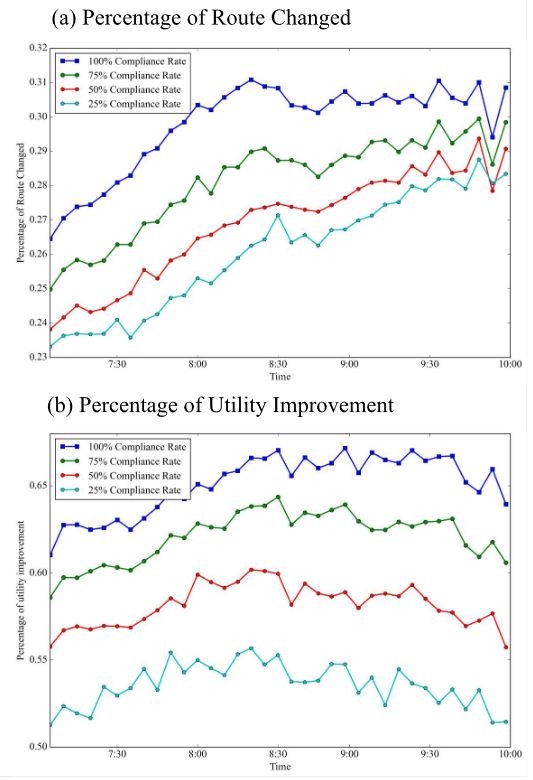

考虑到GRA-TD3的乘客路径诱导可能会牺牲部分乘客的利益,为乘客路径诱导系统的应用带来挑战。因此,本文分析了25%、50%、75%、100%诱导接受度下改变路径的乘客比例以及改变后出行效用提升的乘客比例。如图 9所示。

图 9 不同诱导接受度下改变路径的乘客比例和其中效用提升的比例

在诱导接受度为100%的情况下,改变路径的乘客比例在26%至32%之间,比诱导接受度为25%情况下的提高了3%。另外,当诱导接受度为100%时,约65%的改变路径的乘客获得了更好的出行体验,比25%诱导接受度的情况提高了近10%。证明当乘客遵循路径诱导策略时,乘客更易获得更好的出行体验。

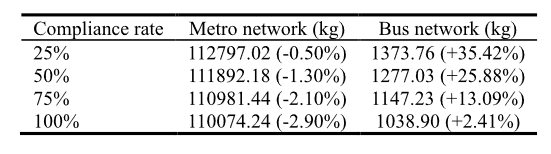

另外,本文计算了不同诱导接受度下二氧化碳的排放情况。表 3为不同诱导接受度下的二氧化碳排放量。在路径诱导策略下,随着诱导接受度的提升,二氧化碳排放量逐渐下降。

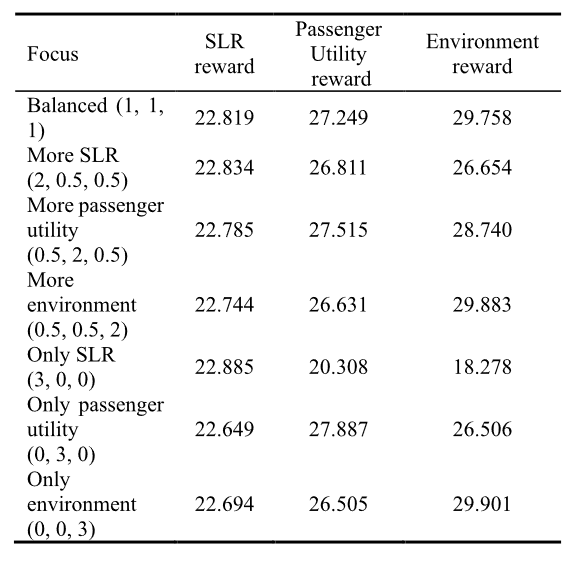

在实际运营中,运营者针对不同的运营重点,需要不同的乘客路径诱导策略。不同子奖励权重下的GRA-TD3性能如表 4所示。在训练GRA-TD3时,权重之和应设置为3,否则在反向传播过程中会导致不一样的梯度传播量级。以 SLR 奖励为例,RL智能体越专注于缓解多模式公交网络的拥堵情况,RL智能体获得的路段满载率奖励就越大。因此,子奖励的权重可以很好地满足运营商的要求,有助于生成适应运营场景的乘客路径诱导策略。

注:a括号中的数值分别代表对路段满载率奖励、乘客效用奖励和碳排放奖励的权重

5 结论

本文提出了一种在多模式公交网络中诱导乘客路径选择的新方法。基于建立的多模式公交线网和状态、动作、奖励函数等强化学习要素,提出了一种新颖的RL算法,来最小化加权求和路段满载率、最大化乘客效用并最小化二氧化碳排放。所提出的RL算法考虑当前多模式公交线网状态(路段满载率和站台等待的乘客数量)和下一阶段乘客出行需求,生成动态的乘客路径诱导策略。首先,为了提取多模式公交线网的状态,引入CNN和自注意力层捕获网络负载和车站候车乘客数量的特征。其次,结合图表示模型来感知下一阶段乘客的出行需求。本算法在北京多模式公交线网上进行了评估。仿真结果表明所提出的GRA模块和GRA-TD3算法是有效的。与没有路径诱导的现实场景相比,GRA-TD3算法显著缓解了网络拥堵,改善了乘客出行体验,并减少了二氧化碳排放,说明RL智能体习得了如何优化多模式公交线网的运力资源。在路径诱导的影响下,约30%的乘客路径发生改变,并有65%的乘客获得效用提高。因此,通过一定的激励措施引导乘客改变出行路径是非常可行的。总而言之,乘客路径诱导策略可以帮助运营商在给定的网络状态下为每个O - D确定一条路径,以实现更好的运营。

本文所进行的研究还有待进一步完善,比如对路径诱导的遵从行为进行建模。这有助于RL智能体了解乘客的行为,从而有针对性地进行诱导。从现实情况来看,真实数据的应用或验证可以进一步增强研究结论的可信度。此外,考虑到在现实环境中引导乘客的路径选择是具有挑战性的,可以对乘客接受路径诱导的激励政策开展研究。此外,随着MaaS的发展,预约和一站式出行可能会得到广泛应用,这会对开发路线诱导系统产生帮助。